注意

跳到結尾以下載完整的範例程式碼。或透過 JupyterLite 或 Binder 在您的瀏覽器中執行此範例

使用堆疊結合預測器#

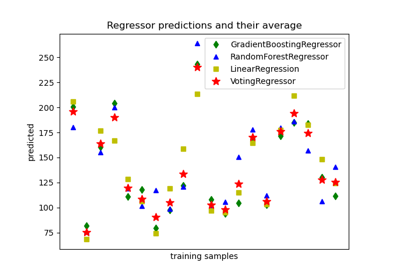

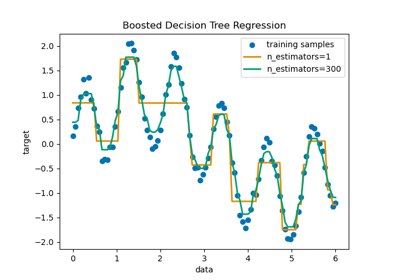

堆疊是指混合估計器的方法。在這個策略中,一些估計器會個別擬合一些訓練資料,同時使用這些基礎估計器的堆疊預測來訓練最終的估計器。

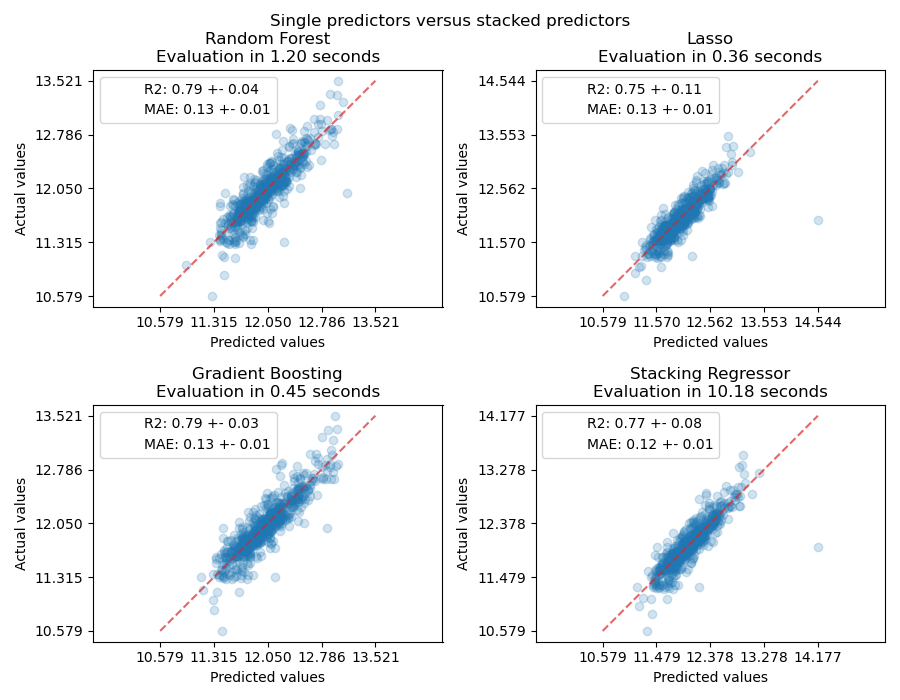

在這個範例中,我們說明了將不同的迴歸器堆疊在一起,並使用最終的線性懲罰迴歸器來輸出預測的用例。我們會將每個個別迴歸器的效能與堆疊策略進行比較。堆疊會稍微改善整體效能。

# Authors: The scikit-learn developers

# SPDX-License-Identifier: BSD-3-Clause

下載資料集#

我們將使用 Ames Housing 資料集,該資料集最初由 Dean De Cock 編譯,並在用於 Kaggle 挑戰賽後變得更加知名。這是位於愛荷華州艾姆斯市的 1460 個住宅房屋的集合,每個房屋都有 80 個特徵描述。我們將使用它來預測房屋的最終對數價格。在這個範例中,我們將僅使用 GradientBoostingRegressor() 選擇的 20 個最有趣的特徵,並限制條目數量(這裡我們不會詳細介紹如何選擇最有趣的特徵)。

Ames 房屋資料集未隨 scikit-learn 提供,因此我們將從 OpenML 提取它。

import numpy as np

from sklearn.datasets import fetch_openml

from sklearn.utils import shuffle

def load_ames_housing():

df = fetch_openml(name="house_prices", as_frame=True)

X = df.data

y = df.target

features = [

"YrSold",

"HeatingQC",

"Street",

"YearRemodAdd",

"Heating",

"MasVnrType",

"BsmtUnfSF",

"Foundation",

"MasVnrArea",

"MSSubClass",

"ExterQual",

"Condition2",

"GarageCars",

"GarageType",

"OverallQual",

"TotalBsmtSF",

"BsmtFinSF1",

"HouseStyle",

"MiscFeature",

"MoSold",

]

X = X.loc[:, features]

X, y = shuffle(X, y, random_state=0)

X = X.iloc[:600]

y = y.iloc[:600]

return X, np.log(y)

X, y = load_ames_housing()

建立管道以預處理資料#

在我們可以使用 Ames 資料集之前,仍然需要做一些預處理。首先,我們將選擇資料集的類別和數值欄位,以建構管道的第一步。

from sklearn.compose import make_column_selector

cat_selector = make_column_selector(dtype_include=object)

num_selector = make_column_selector(dtype_include=np.number)

cat_selector(X)

['HeatingQC', 'Street', 'Heating', 'MasVnrType', 'Foundation', 'ExterQual', 'Condition2', 'GarageType', 'HouseStyle', 'MiscFeature']

num_selector(X)

['YrSold', 'YearRemodAdd', 'BsmtUnfSF', 'MasVnrArea', 'MSSubClass', 'GarageCars', 'OverallQual', 'TotalBsmtSF', 'BsmtFinSF1', 'MoSold']

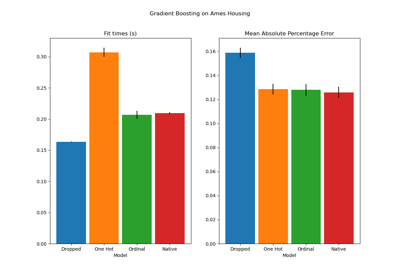

然後,我們需要設計預處理管道,這取決於最終迴歸器。如果最終迴歸器是線性模型,則需要對類別進行單熱編碼。如果最終迴歸器是基於樹狀的模型,則序數編碼器就足夠了。此外,數值需要針對線性模型進行標準化,而基於樹狀的模型可以按原樣處理原始數值資料。但是,這兩個模型都需要一個插補器來處理遺失的值。

我們將首先設計基於樹狀模型所需的管道。

from sklearn.compose import make_column_transformer

from sklearn.impute import SimpleImputer

from sklearn.pipeline import make_pipeline

from sklearn.preprocessing import OrdinalEncoder

cat_tree_processor = OrdinalEncoder(

handle_unknown="use_encoded_value",

unknown_value=-1,

encoded_missing_value=-2,

)

num_tree_processor = SimpleImputer(strategy="mean", add_indicator=True)

tree_preprocessor = make_column_transformer(

(num_tree_processor, num_selector), (cat_tree_processor, cat_selector)

)

tree_preprocessor

然後,我們現在將定義最終迴歸器為線性模型時使用的預處理器。

from sklearn.preprocessing import OneHotEncoder, StandardScaler

cat_linear_processor = OneHotEncoder(handle_unknown="ignore")

num_linear_processor = make_pipeline(

StandardScaler(), SimpleImputer(strategy="mean", add_indicator=True)

)

linear_preprocessor = make_column_transformer(

(num_linear_processor, num_selector), (cat_linear_processor, cat_selector)

)

linear_preprocessor

單一資料集上的預測器堆疊#

有時很難找到在給定資料集上效能最佳的模型。堆疊提供了一種替代方案,透過結合多個學習器的輸出,而無需特意選擇模型。堆疊的效能通常接近最佳模型,有時它可以勝過每個個別模型的預測效能。

在這裡,我們結合了 3 個學習器(線性和非線性),並使用嶺迴歸器將其輸出結合在一起。

注意

雖然我們會使用在前一節中為 3 個學習器編寫的處理器建立新的管道,但最終的估計器 RidgeCV() 不需要預處理資料,因為它將使用來自 3 個學習器的已預處理輸出饋送。

from sklearn.linear_model import LassoCV

lasso_pipeline = make_pipeline(linear_preprocessor, LassoCV())

lasso_pipeline

from sklearn.ensemble import RandomForestRegressor

rf_pipeline = make_pipeline(tree_preprocessor, RandomForestRegressor(random_state=42))

rf_pipeline

from sklearn.ensemble import HistGradientBoostingRegressor

gbdt_pipeline = make_pipeline(

tree_preprocessor, HistGradientBoostingRegressor(random_state=0)

)

gbdt_pipeline

from sklearn.ensemble import StackingRegressor

from sklearn.linear_model import RidgeCV

estimators = [

("Random Forest", rf_pipeline),

("Lasso", lasso_pipeline),

("Gradient Boosting", gbdt_pipeline),

]

stacking_regressor = StackingRegressor(estimators=estimators, final_estimator=RidgeCV())

stacking_regressor

衡量並繪製結果#

現在我們可以使用 Ames 房屋資料集進行預測。我們會檢查每個個別預測器以及迴歸器堆疊的效能。

import time

import matplotlib.pyplot as plt

from sklearn.metrics import PredictionErrorDisplay

from sklearn.model_selection import cross_val_predict, cross_validate

fig, axs = plt.subplots(2, 2, figsize=(9, 7))

axs = np.ravel(axs)

for ax, (name, est) in zip(

axs, estimators + [("Stacking Regressor", stacking_regressor)]

):

scorers = {"R2": "r2", "MAE": "neg_mean_absolute_error"}

start_time = time.time()

scores = cross_validate(

est, X, y, scoring=list(scorers.values()), n_jobs=-1, verbose=0

)

elapsed_time = time.time() - start_time

y_pred = cross_val_predict(est, X, y, n_jobs=-1, verbose=0)

scores = {

key: (

f"{np.abs(np.mean(scores[f'test_{value}'])):.2f} +- "

f"{np.std(scores[f'test_{value}']):.2f}"

)

for key, value in scorers.items()

}

display = PredictionErrorDisplay.from_predictions(

y_true=y,

y_pred=y_pred,

kind="actual_vs_predicted",

ax=ax,

scatter_kwargs={"alpha": 0.2, "color": "tab:blue"},

line_kwargs={"color": "tab:red"},

)

ax.set_title(f"{name}\nEvaluation in {elapsed_time:.2f} seconds")

for name, score in scores.items():

ax.plot([], [], " ", label=f"{name}: {score}")

ax.legend(loc="upper left")

plt.suptitle("Single predictors versus stacked predictors")

plt.tight_layout()

plt.subplots_adjust(top=0.9)

plt.show()

堆疊迴歸器會結合不同迴歸器的優點。但是,我們也看到訓練堆疊迴歸器的計算成本要高得多。

腳本的總執行時間: (0 分鐘 24.854 秒)

相關範例