範例#

這是展示如何使用 scikit-learn 的範例庫。有些範例示範了 API 的一般用法,有些則以教學形式示範了特定應用。此外,請查看我們的 使用者指南 以取得更詳細的說明。

發行重點#

這些範例說明了 scikit-learn 發行版本的主要功能。

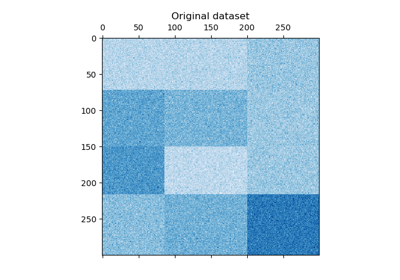

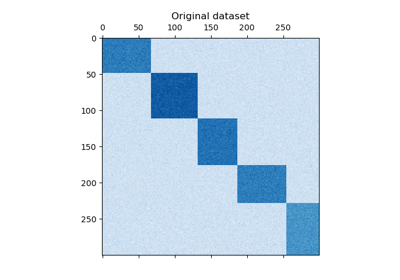

雙向分群#

關於雙向分群技術的範例。

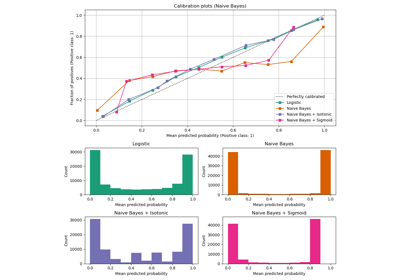

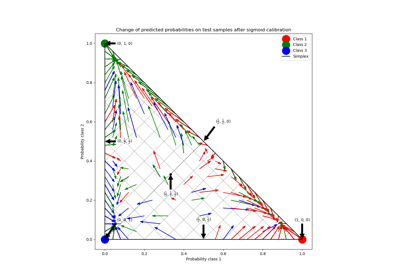

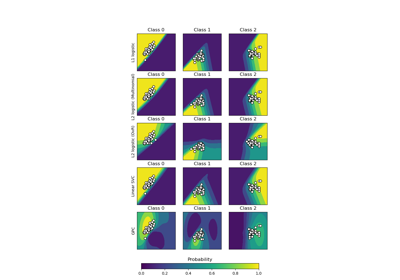

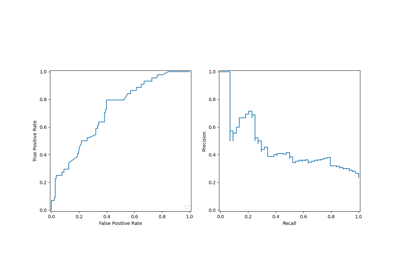

校準#

說明分類器預測機率校準的範例。

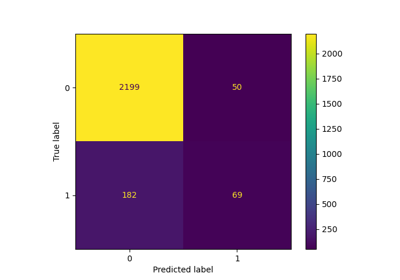

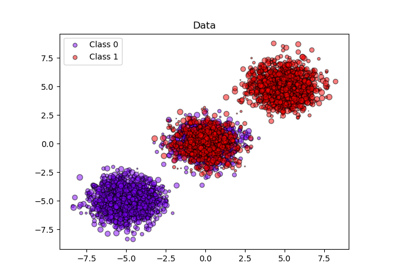

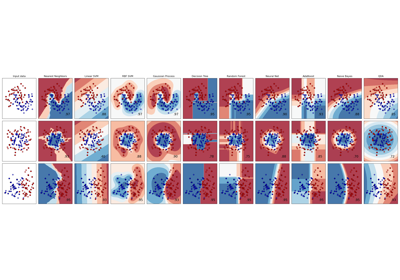

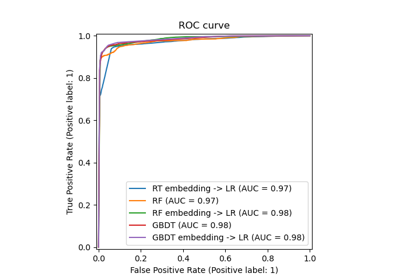

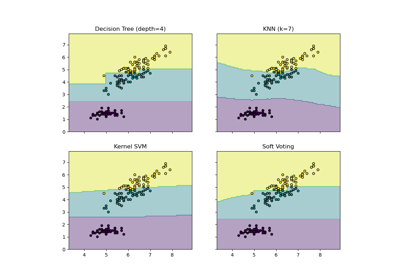

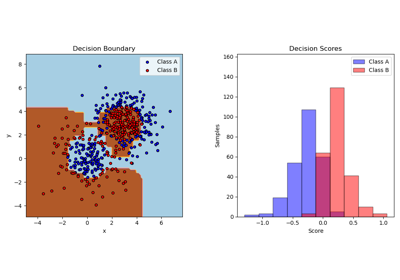

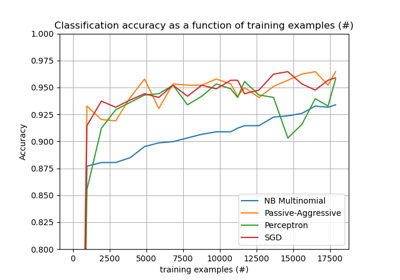

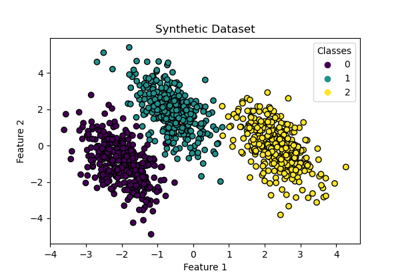

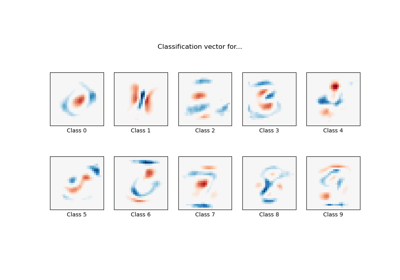

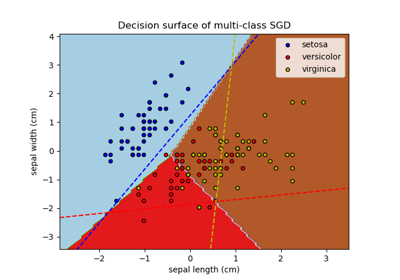

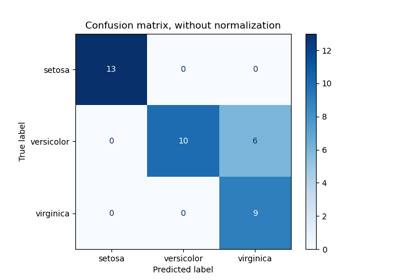

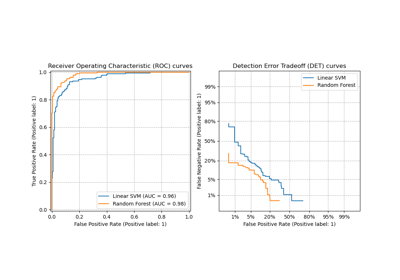

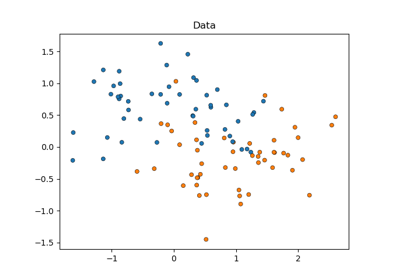

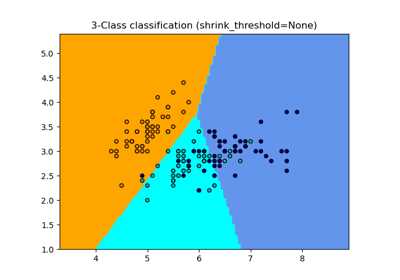

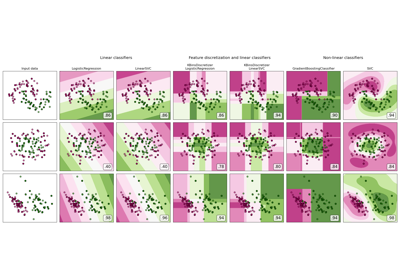

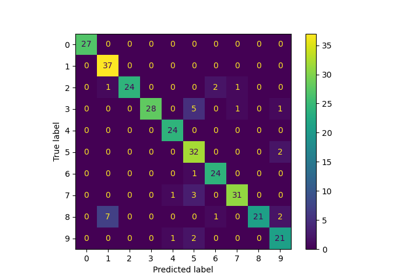

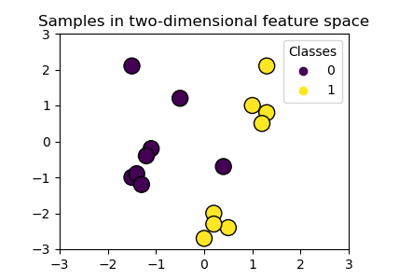

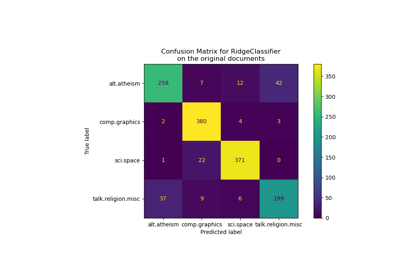

分類#

關於分類演算法的一般範例。

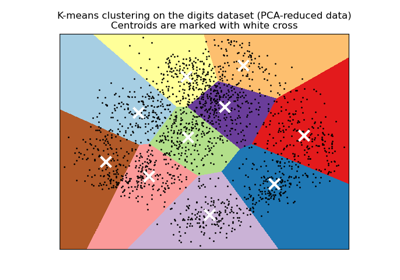

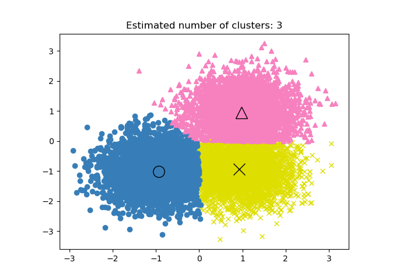

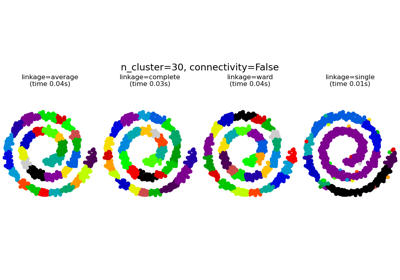

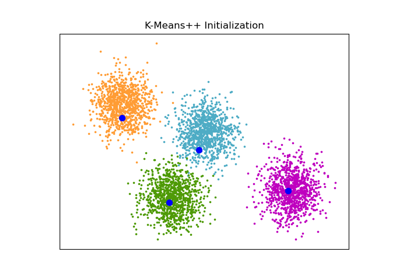

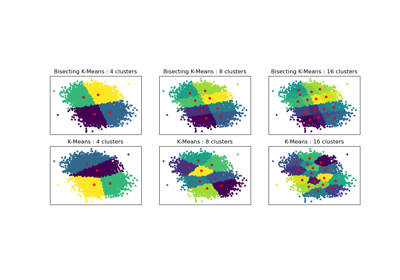

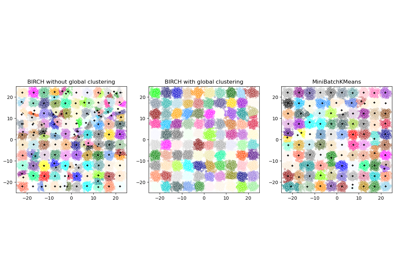

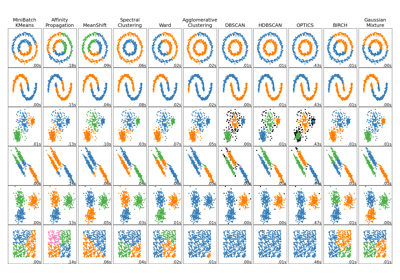

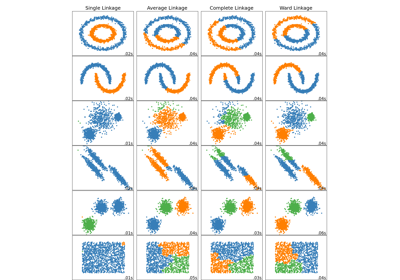

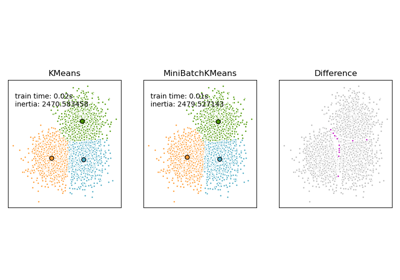

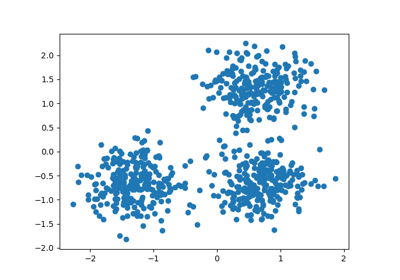

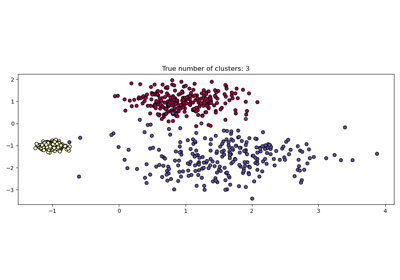

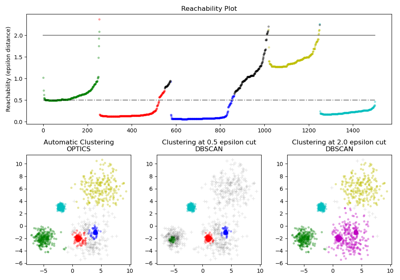

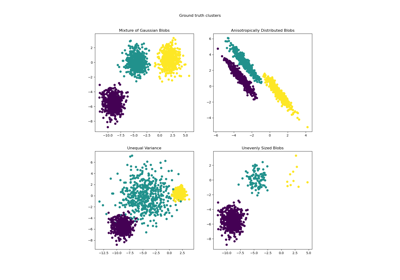

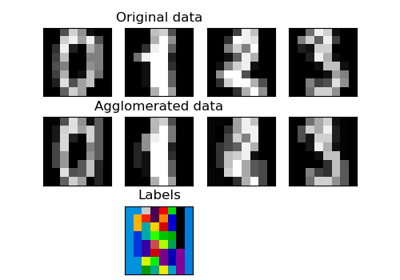

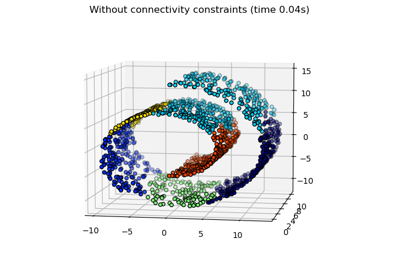

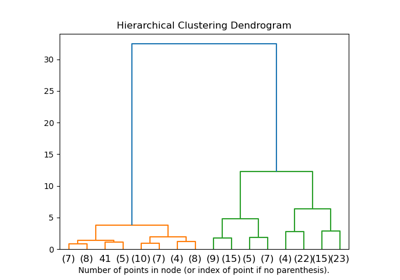

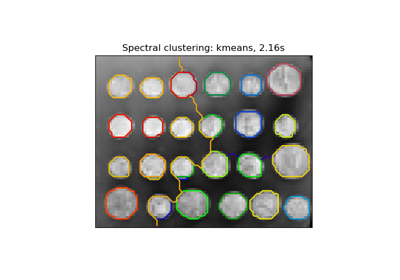

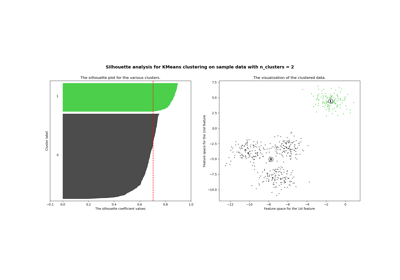

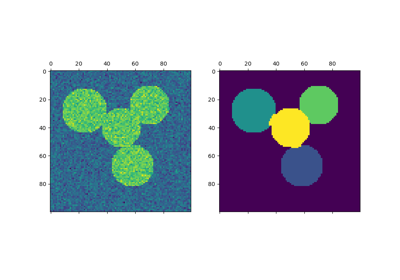

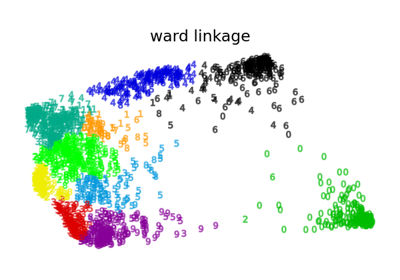

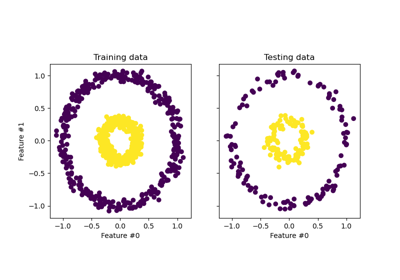

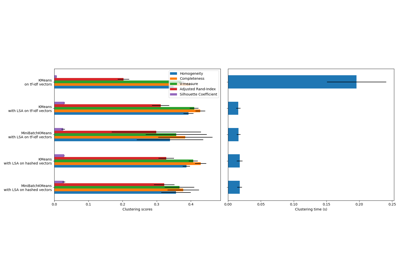

分群#

關於 sklearn.cluster 模組的範例。

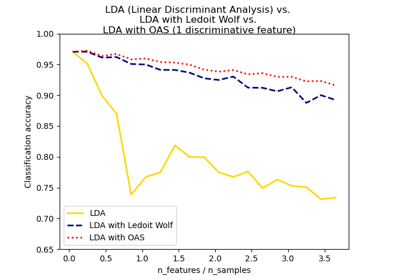

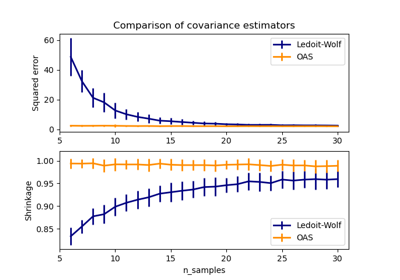

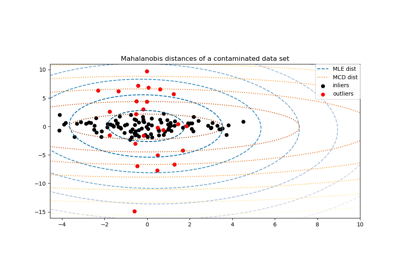

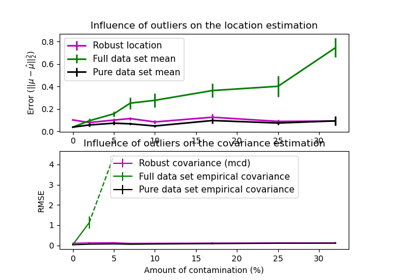

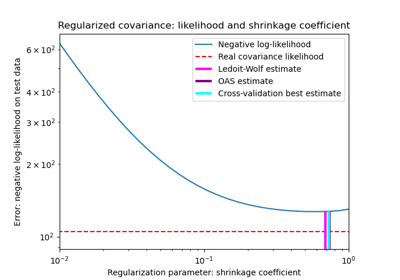

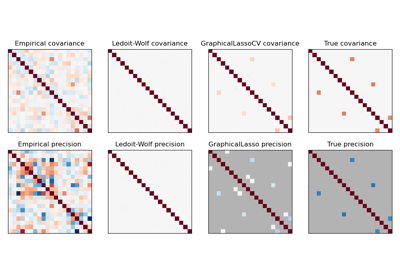

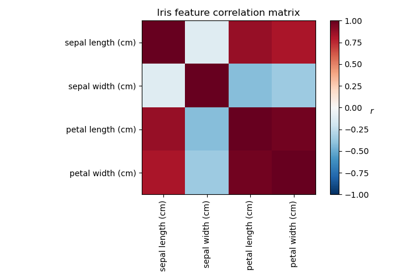

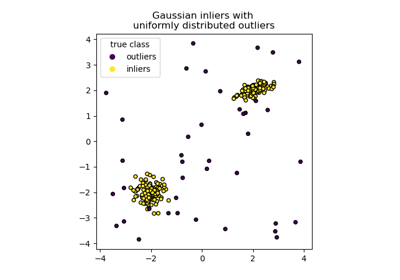

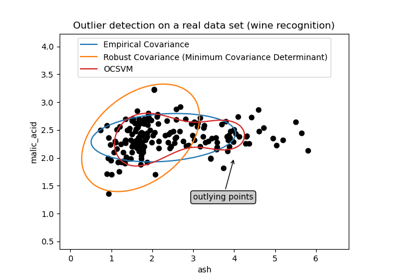

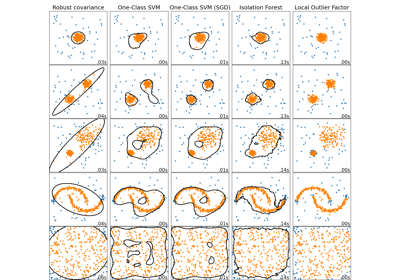

共變異數估計#

關於 sklearn.covariance 模組的範例。

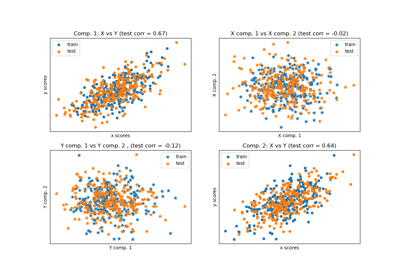

交叉分解#

關於 sklearn.cross_decomposition 模組的範例。

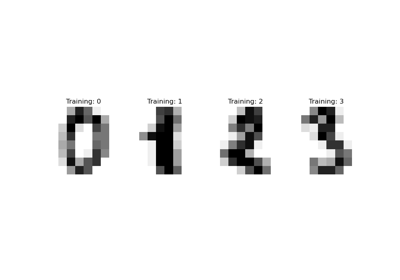

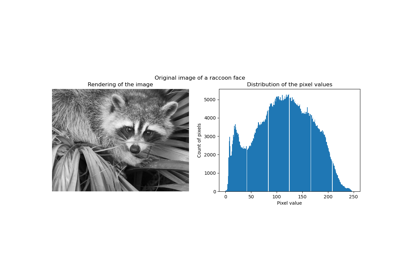

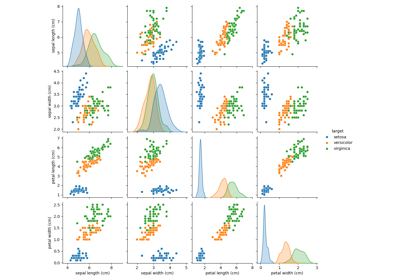

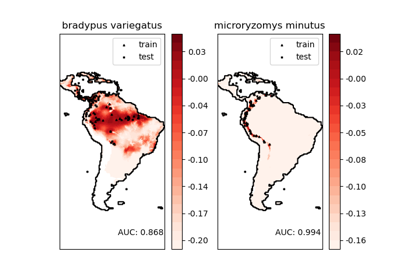

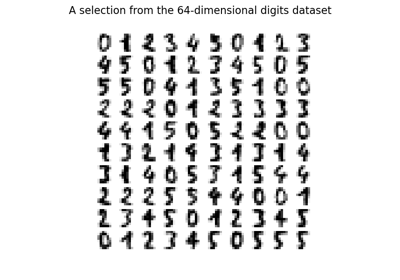

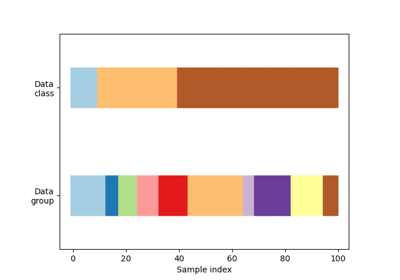

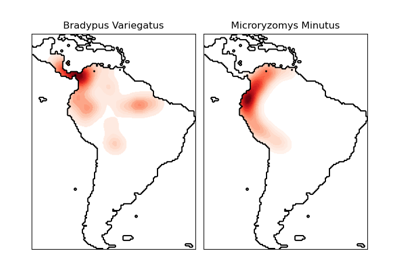

資料集範例#

關於 sklearn.datasets 模組的範例。

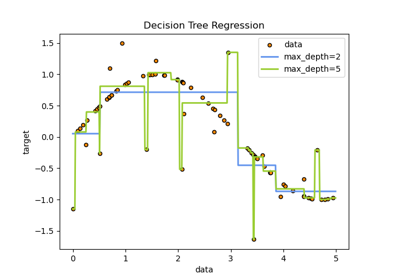

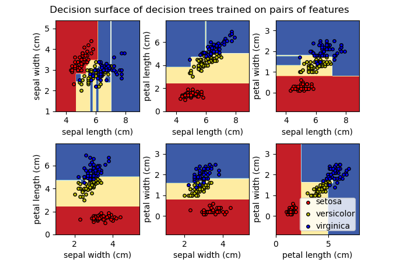

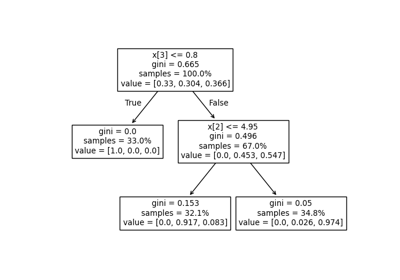

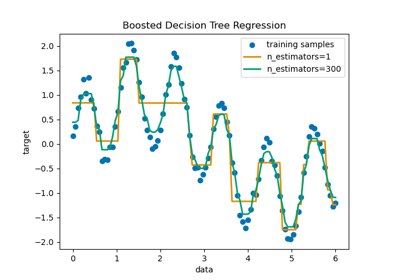

決策樹#

關於 sklearn.tree 模組的範例。

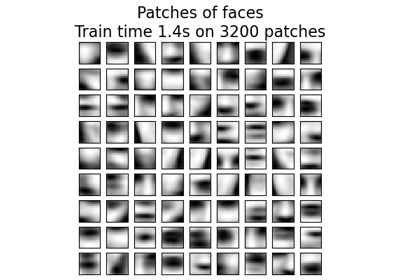

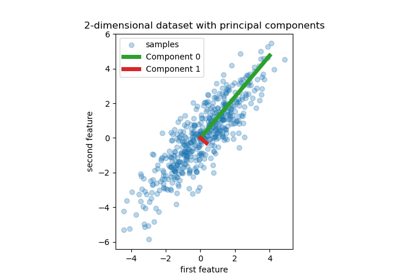

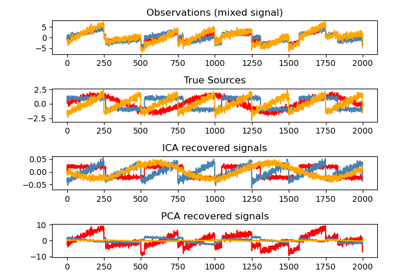

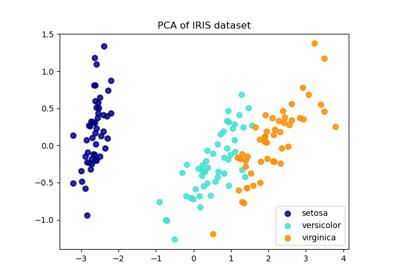

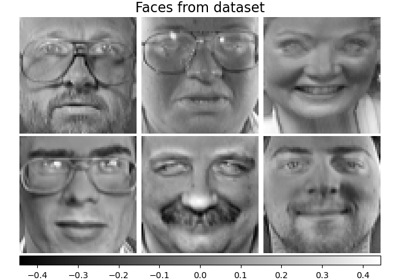

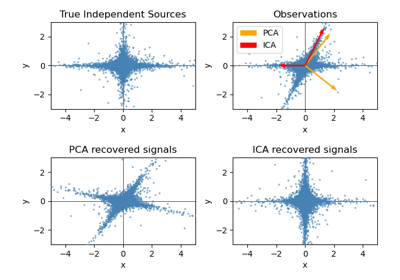

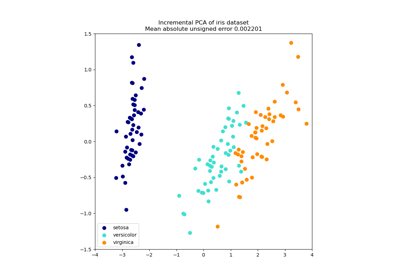

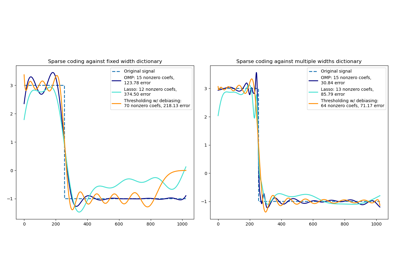

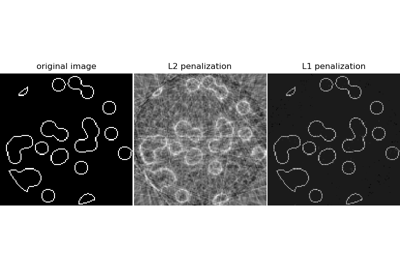

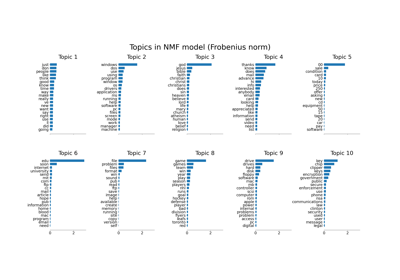

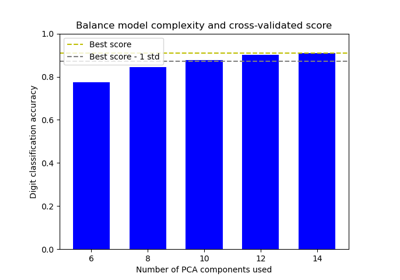

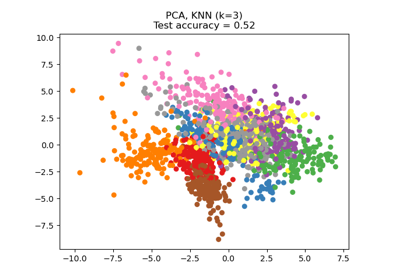

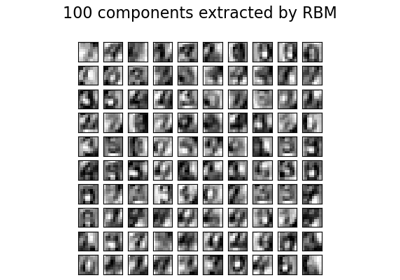

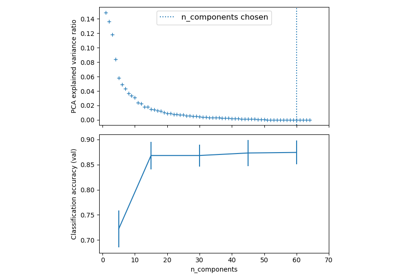

分解#

關於 sklearn.decomposition 模組的範例。

開發估算器#

關於開發自訂估算器的範例。

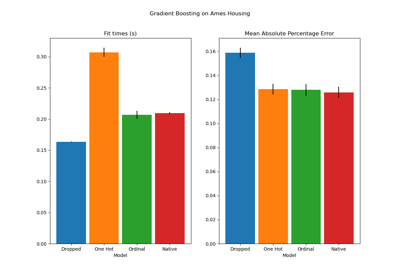

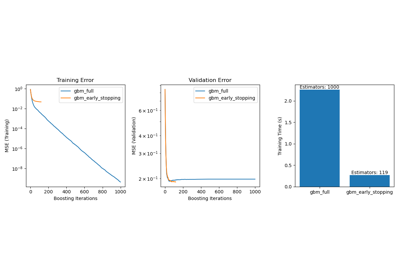

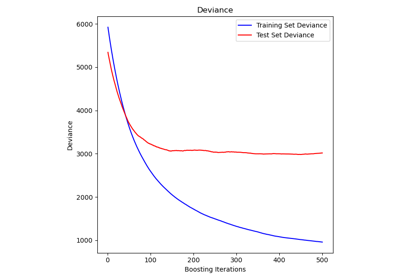

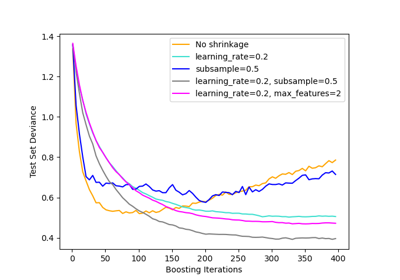

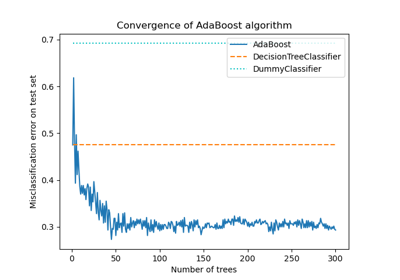

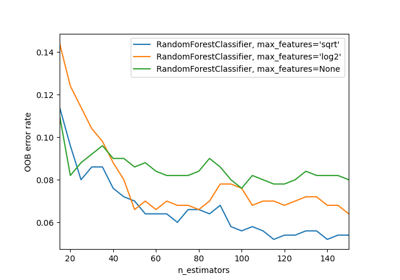

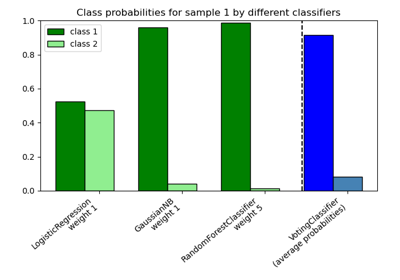

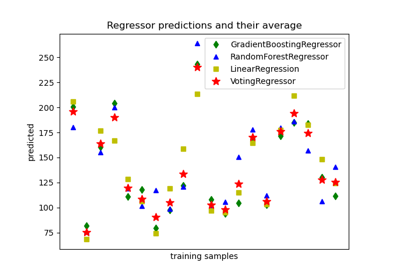

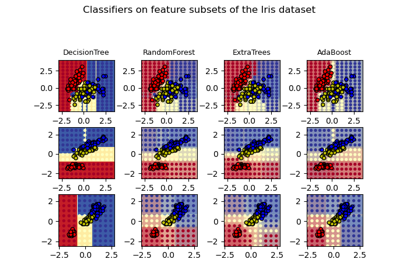

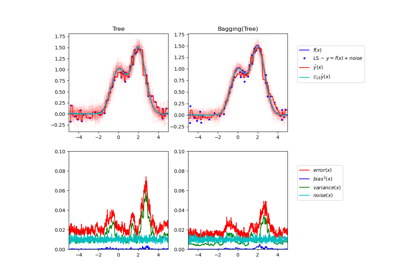

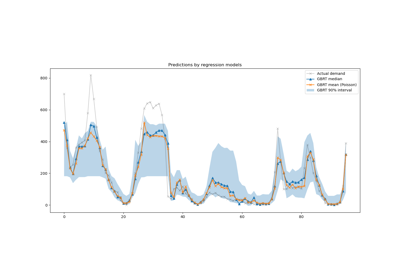

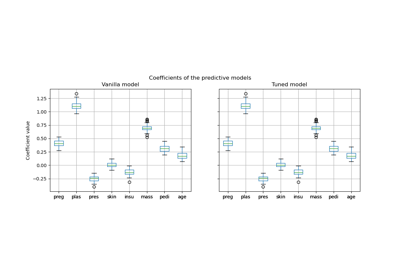

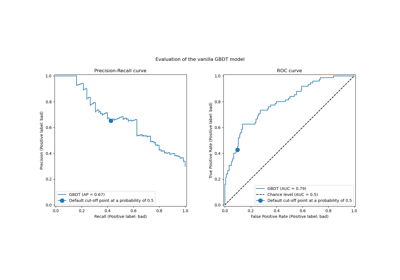

集成方法#

關於 sklearn.ensemble 模組的範例。

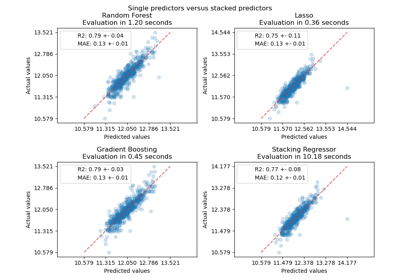

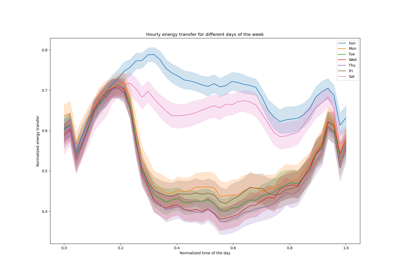

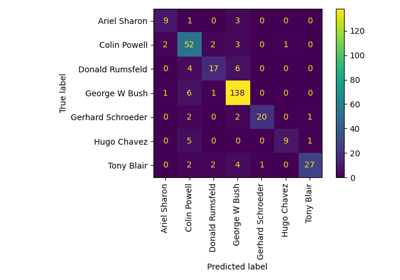

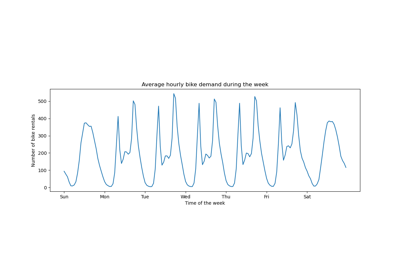

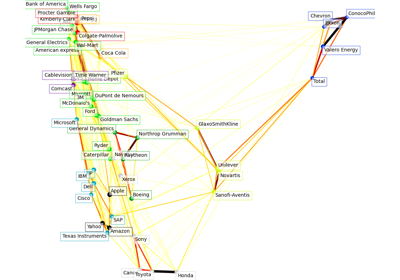

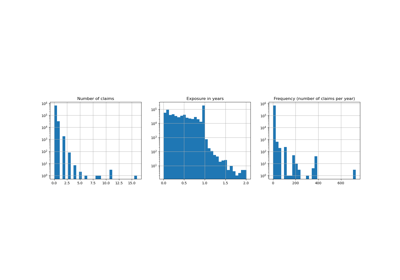

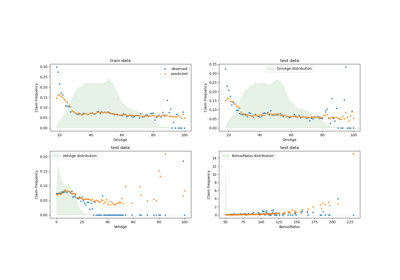

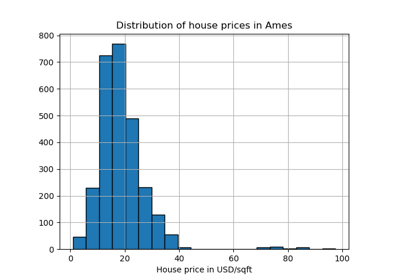

基於真實世界資料集的範例#

將應用程式應用於具有一些中型資料集或互動式使用者介面的真實世界問題。

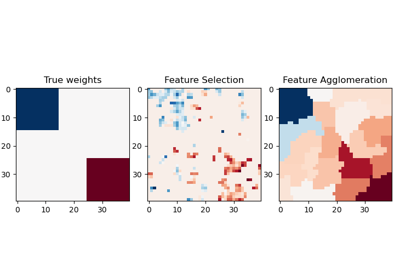

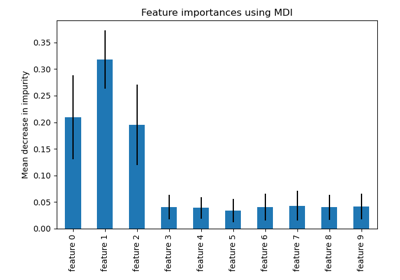

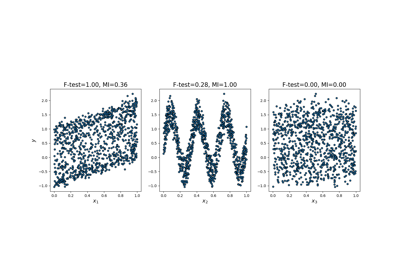

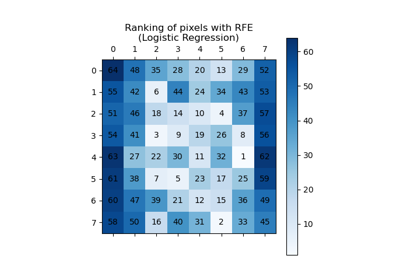

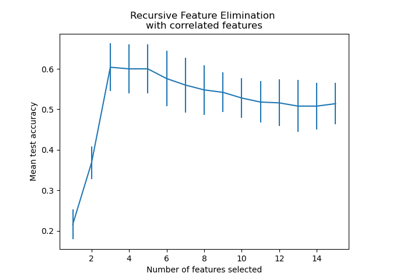

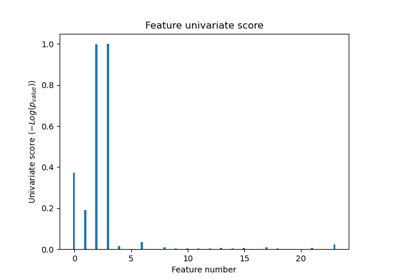

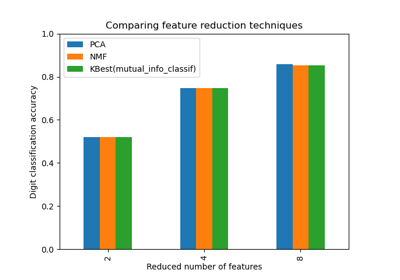

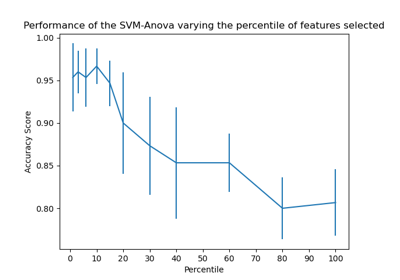

特徵選擇#

關於 sklearn.feature_selection 模組的範例。

凍結估算器#

關於 sklearn.frozen 模組的範例。

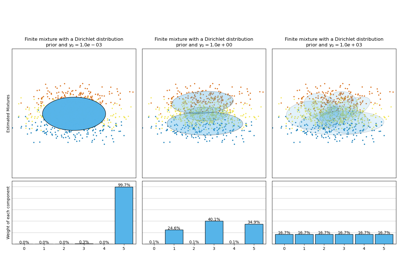

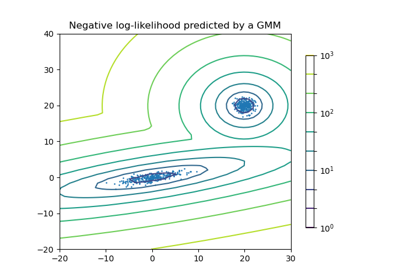

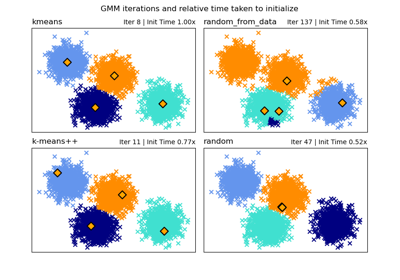

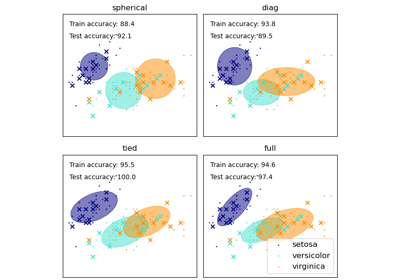

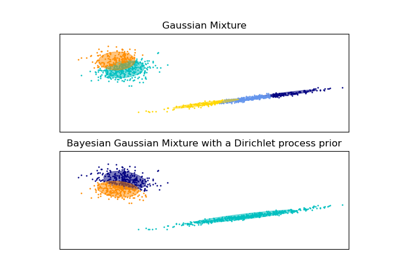

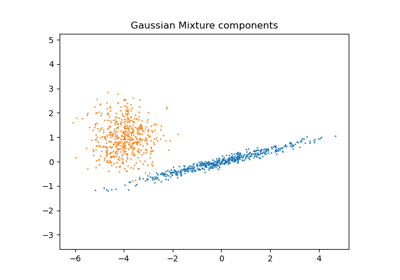

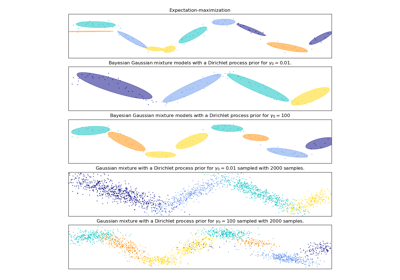

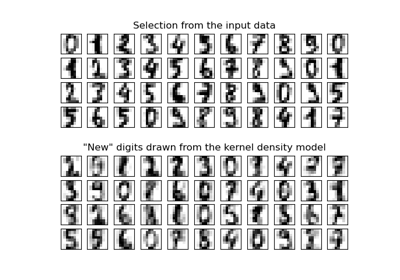

高斯混合模型#

關於 sklearn.mixture 模組的範例。

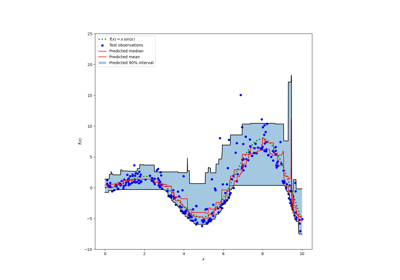

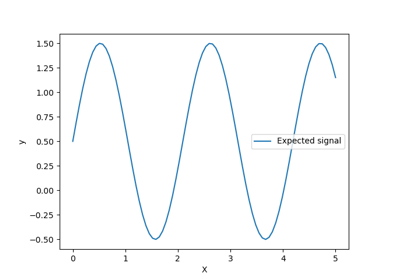

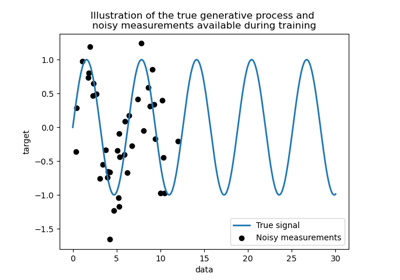

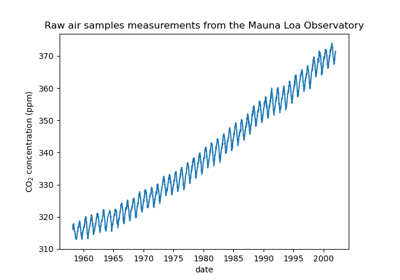

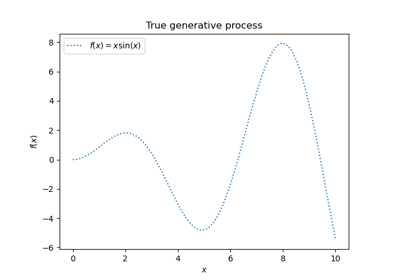

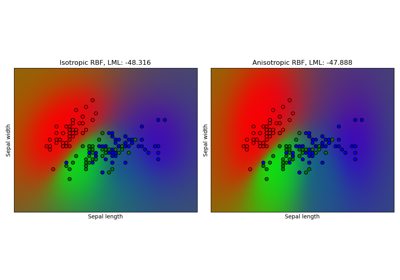

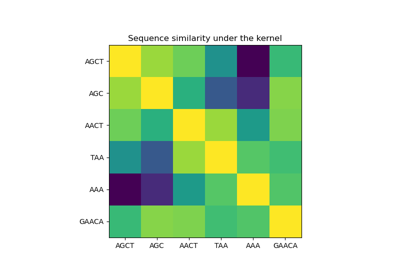

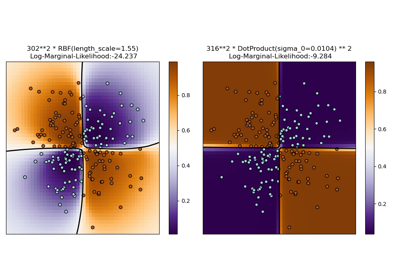

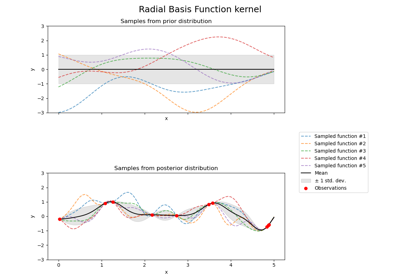

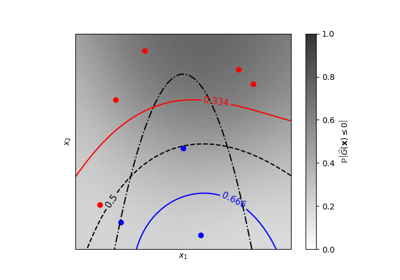

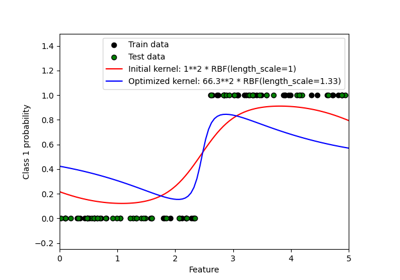

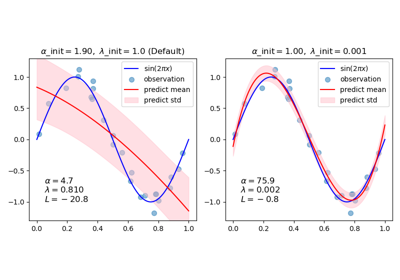

用於機器學習的高斯過程#

關於 sklearn.gaussian_process 模組的範例。

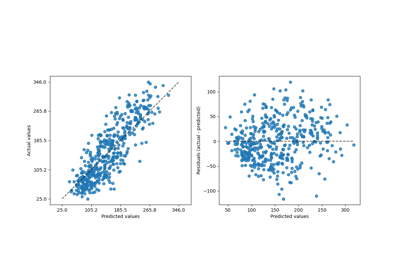

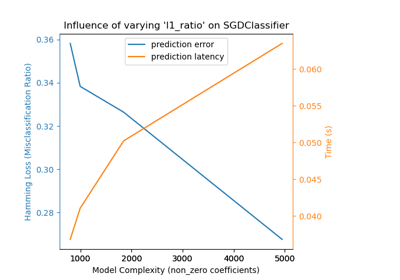

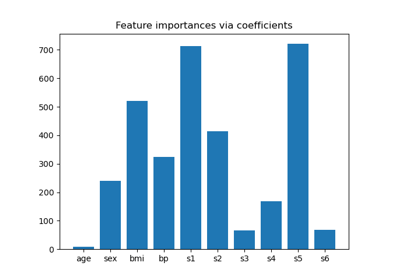

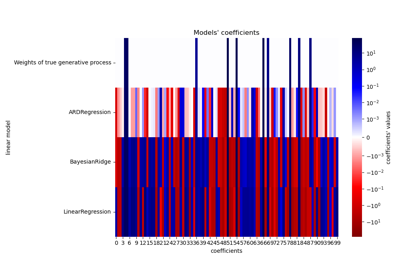

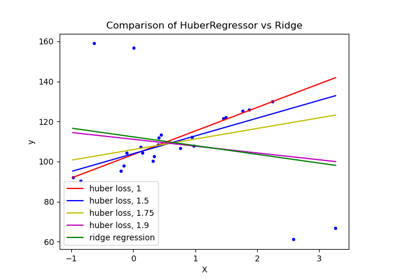

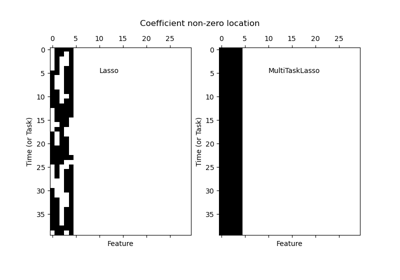

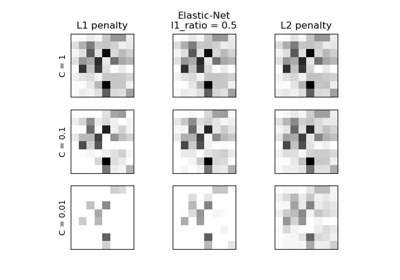

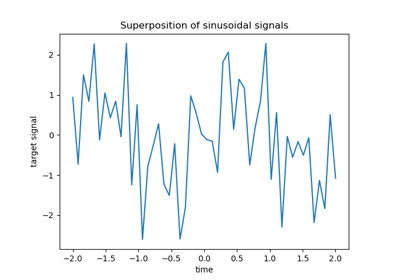

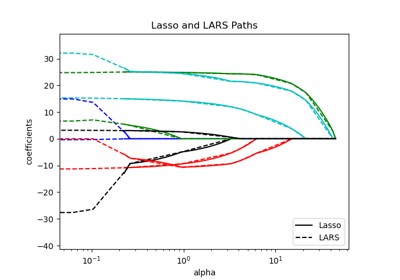

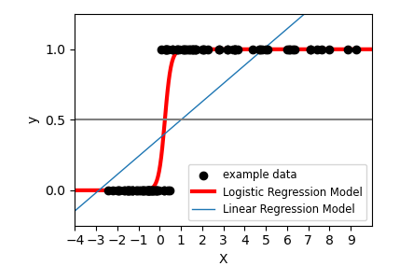

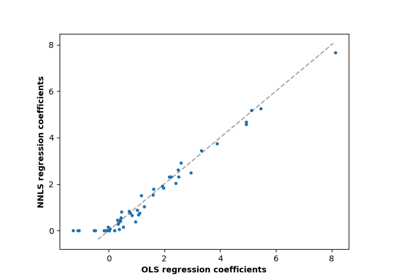

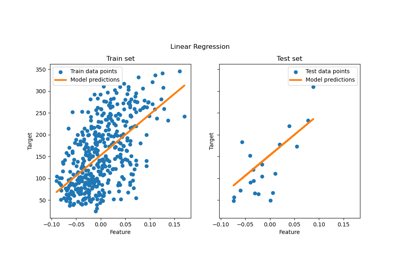

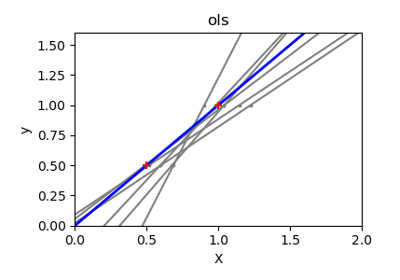

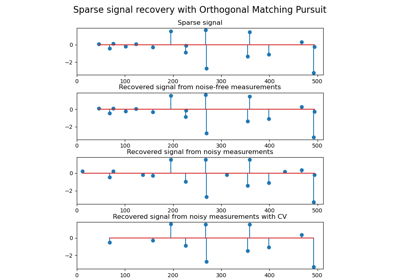

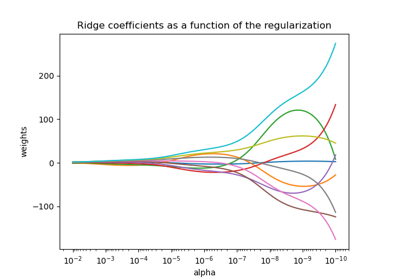

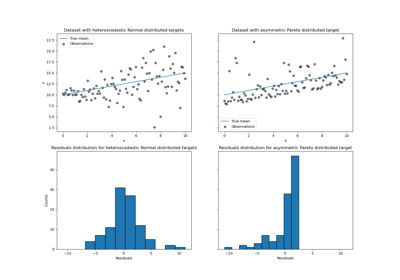

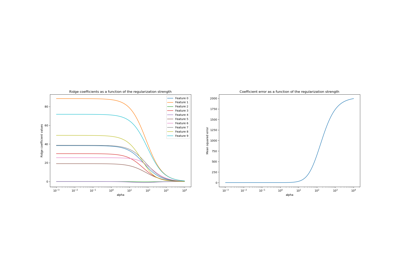

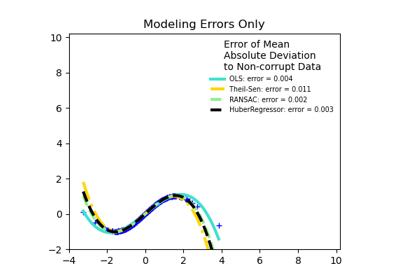

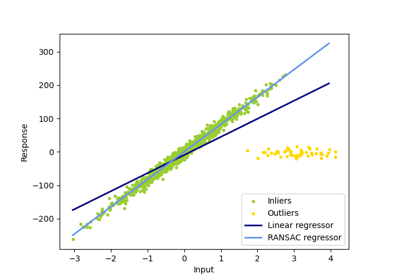

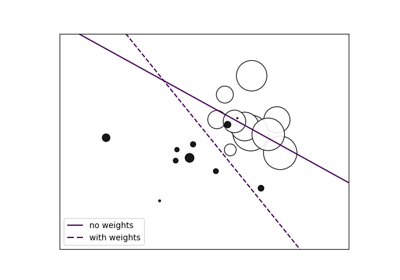

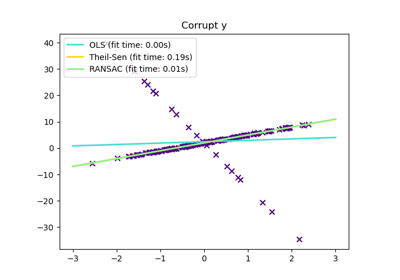

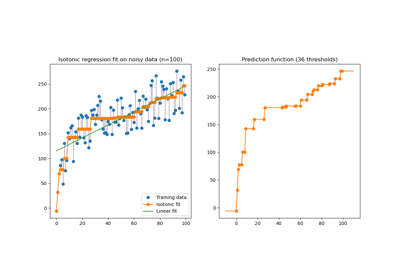

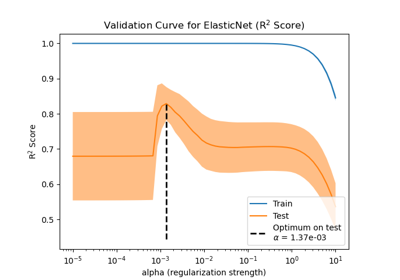

廣義線性模型#

關於 sklearn.linear_model 模組的範例。

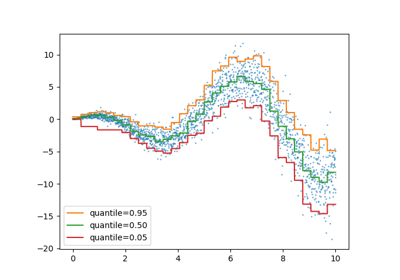

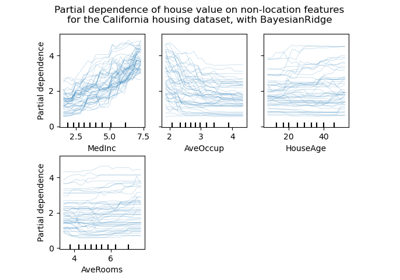

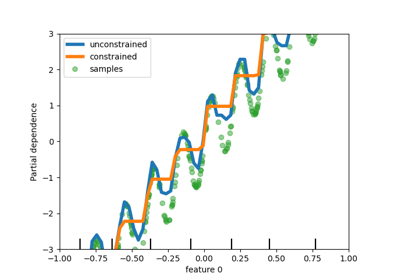

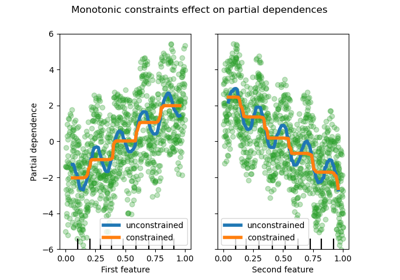

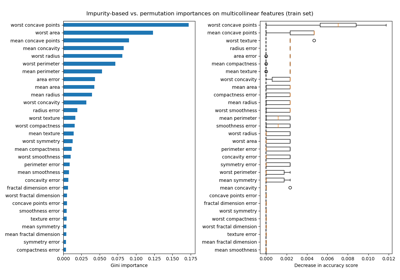

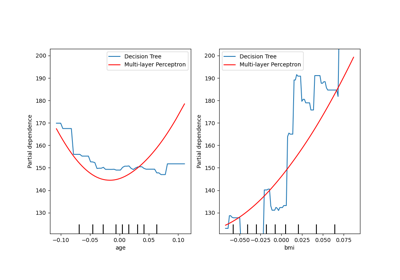

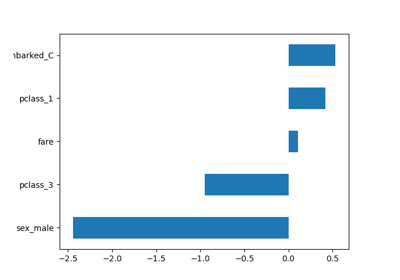

檢查#

關於 sklearn.inspection 模組的範例。

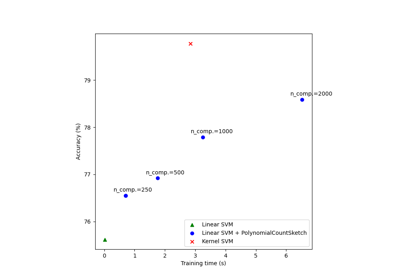

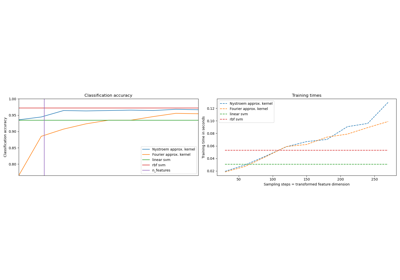

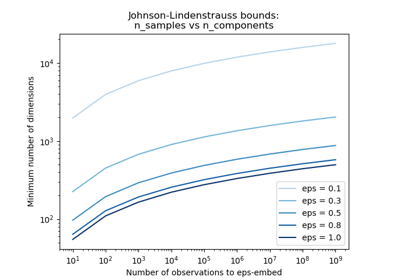

核函數近似#

關於 sklearn.kernel_approximation 模組的範例。

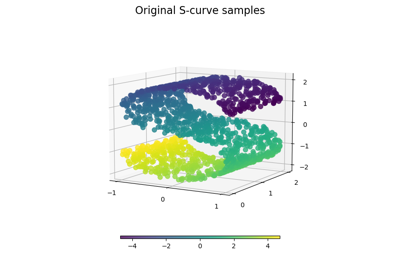

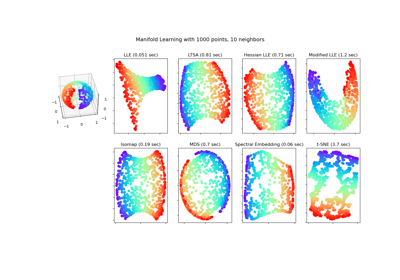

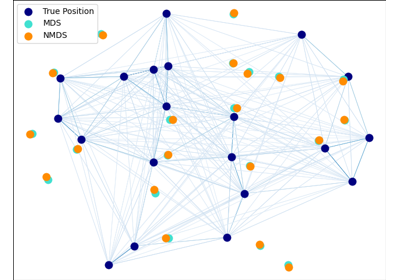

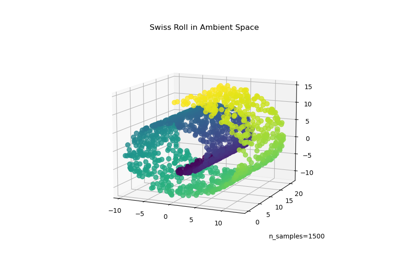

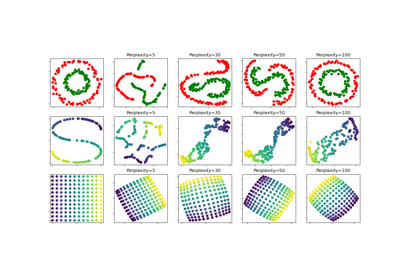

流形學習#

關於 sklearn.manifold 模組的範例。

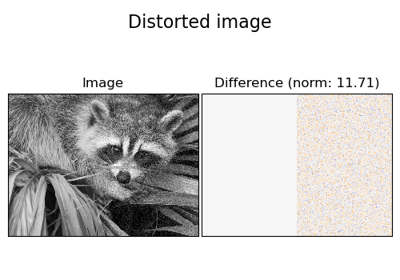

雜項#

scikit-learn 的雜項和入門範例。

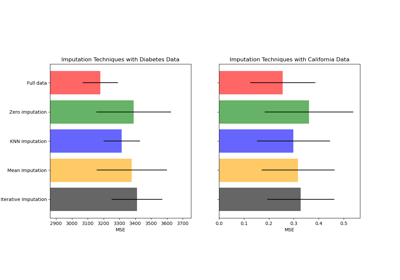

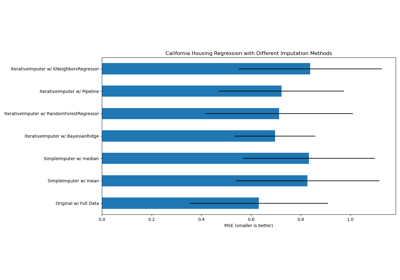

遺失值填補#

關於 sklearn.impute 模組的範例。

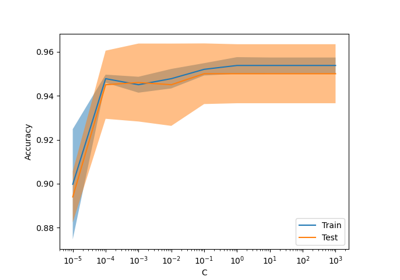

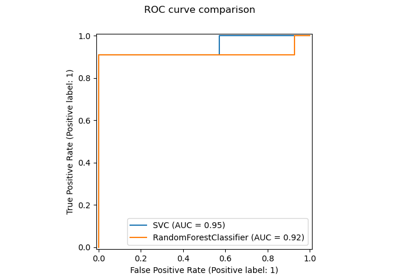

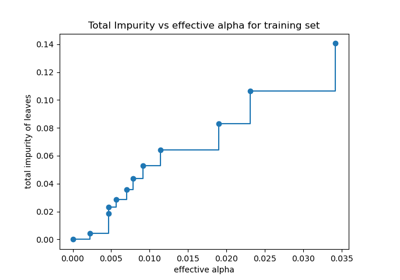

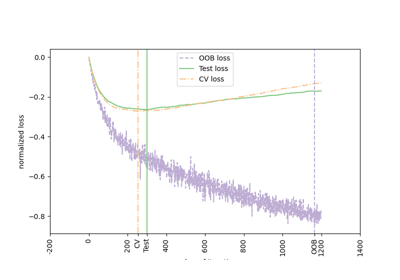

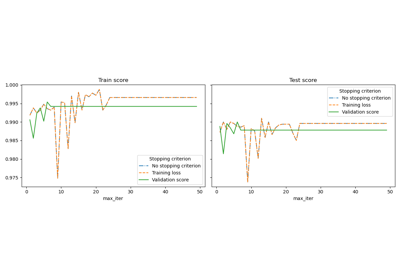

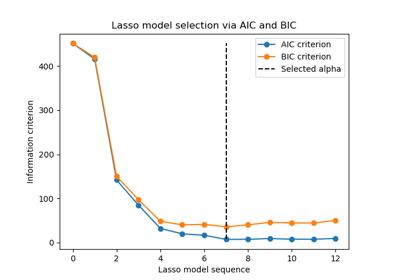

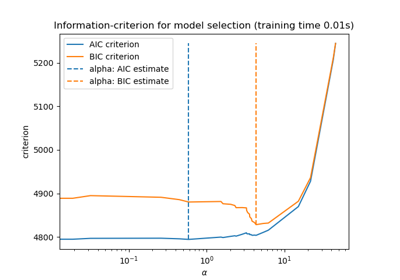

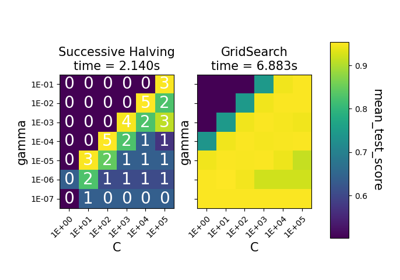

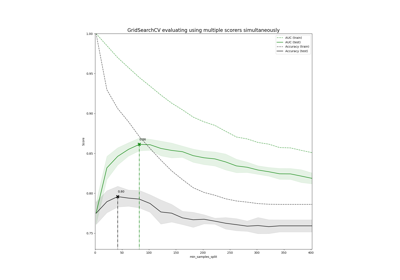

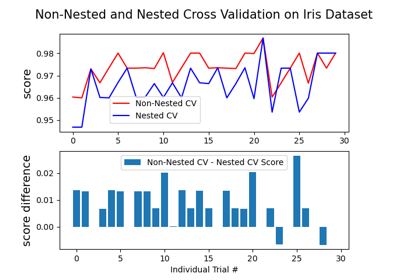

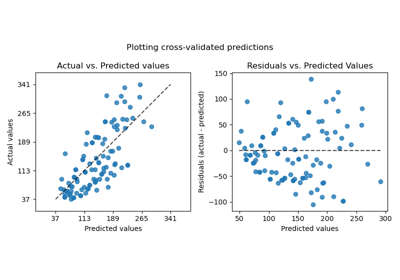

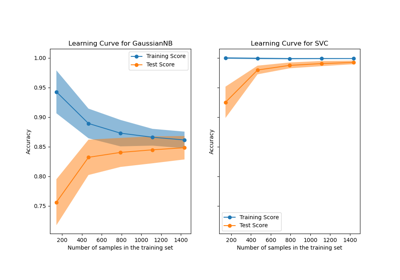

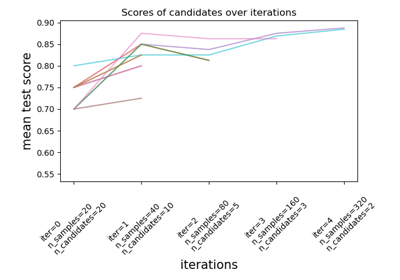

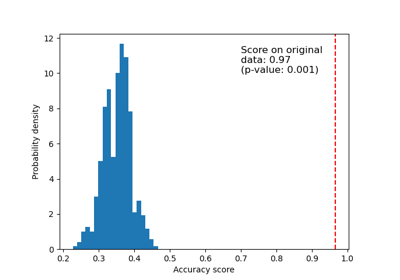

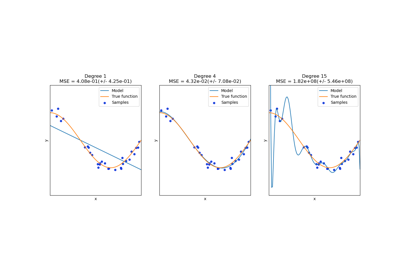

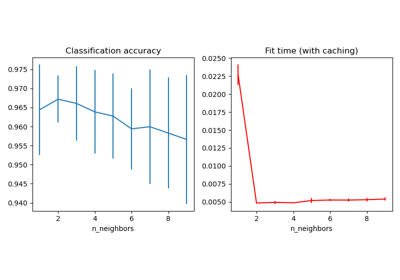

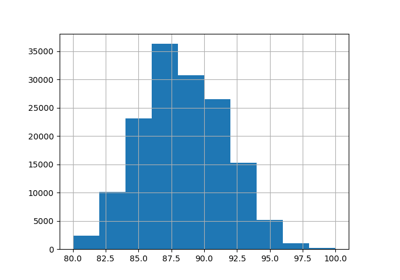

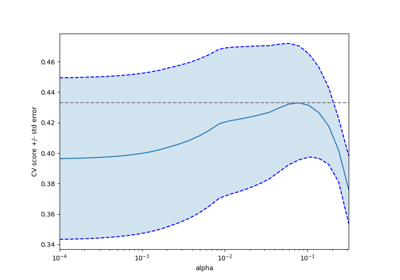

模型選擇#

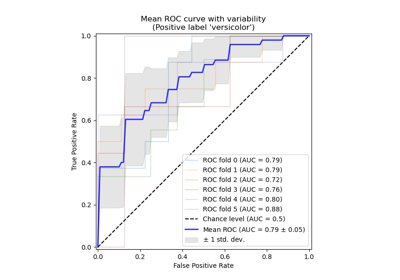

關於 sklearn.model_selection 模組的範例。

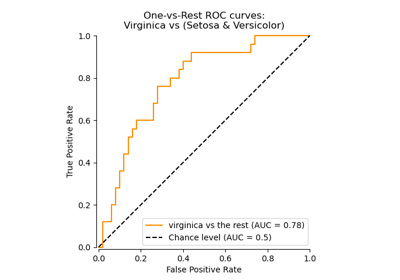

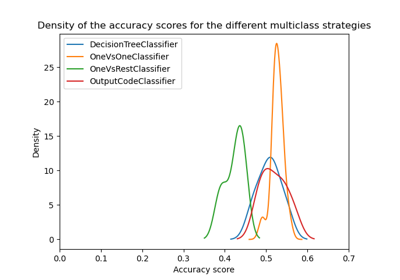

多類別方法#

關於 sklearn.multiclass 模組的範例。

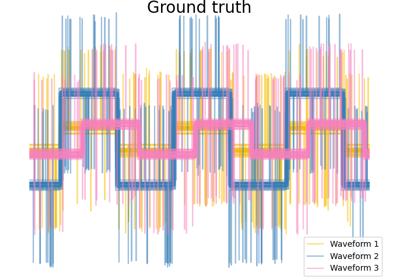

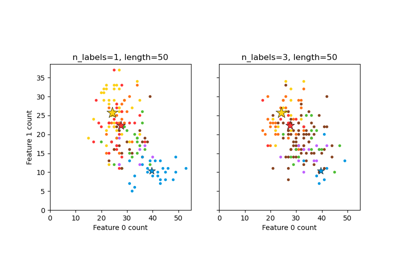

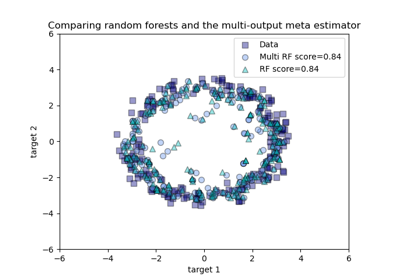

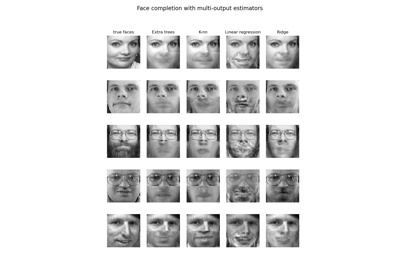

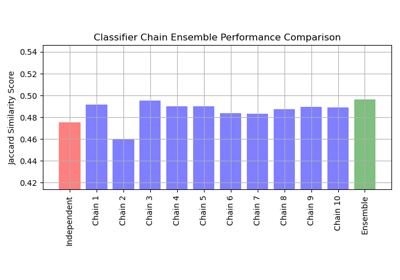

多輸出方法#

關於 sklearn.multioutput 模組的範例。

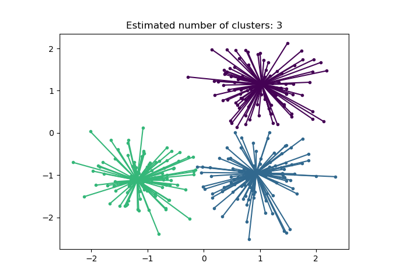

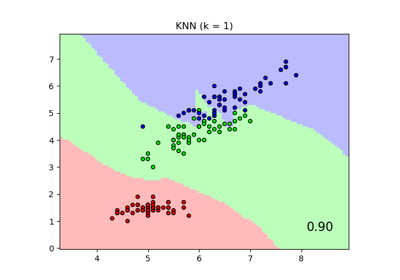

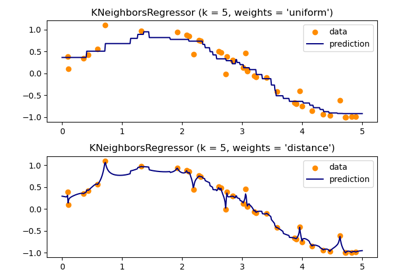

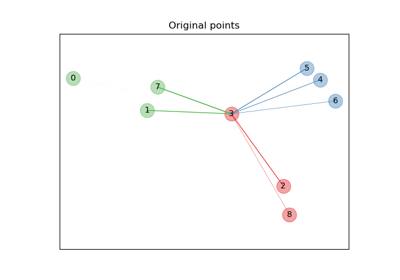

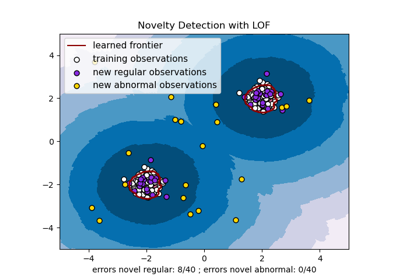

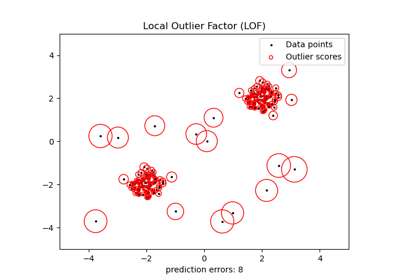

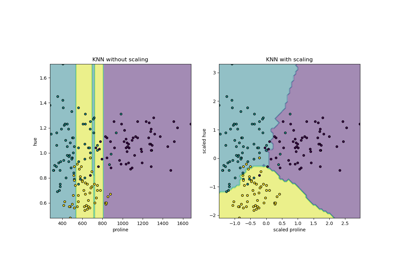

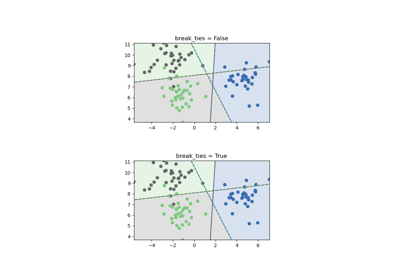

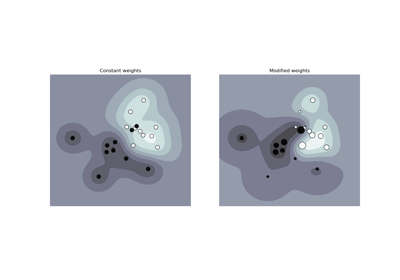

最近鄰居#

關於 sklearn.neighbors 模組的範例。

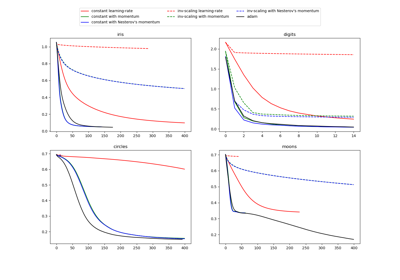

神經網路#

關於 sklearn.neural_network 模組的範例。

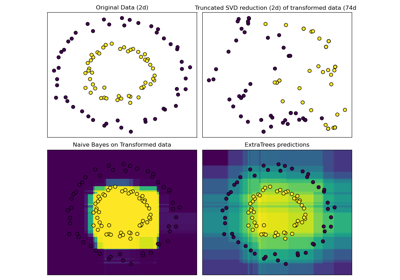

管線和複合估算器#

說明如何從其他估算器組合轉換器和管線的範例。請參閱使用者指南。

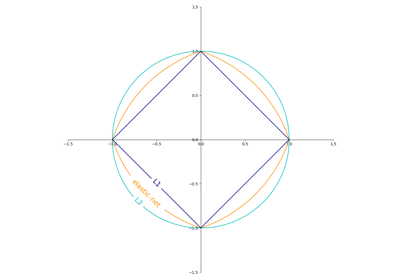

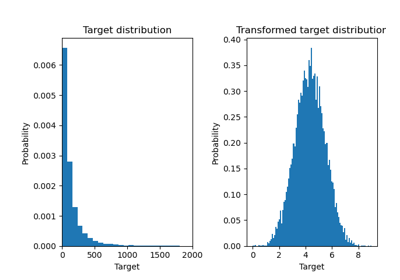

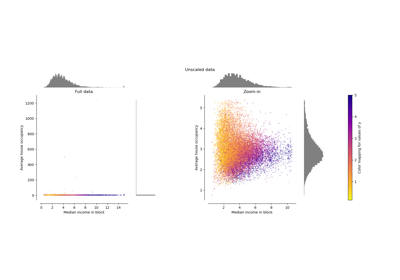

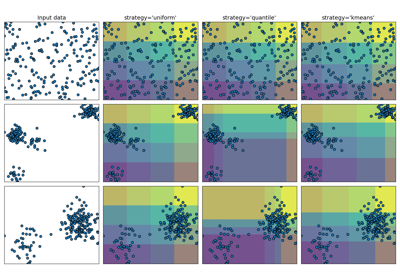

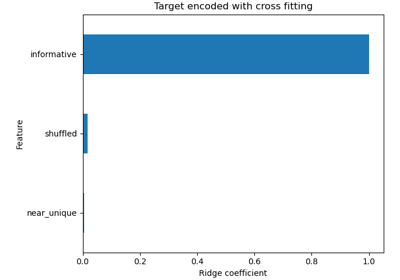

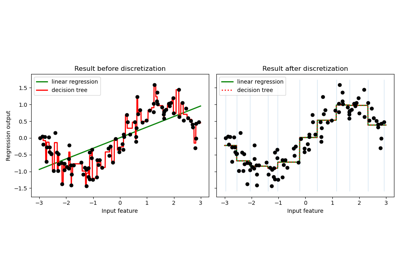

預處理#

關於 sklearn.preprocessing 模組的範例。

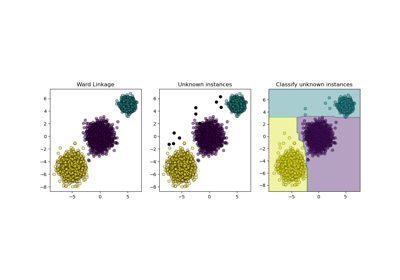

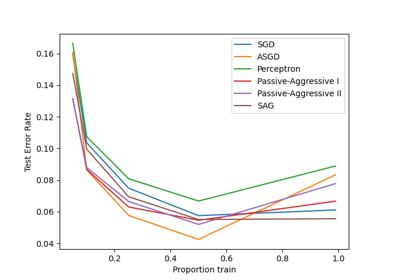

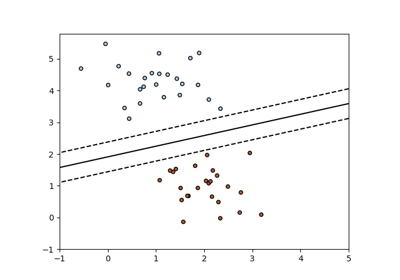

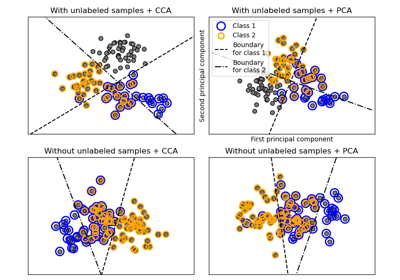

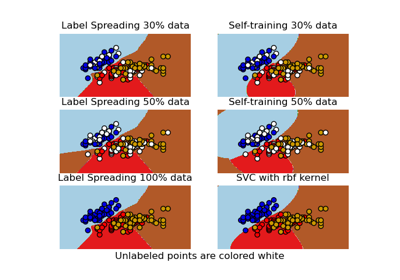

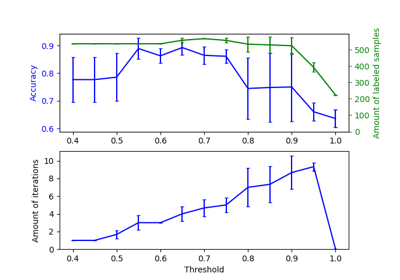

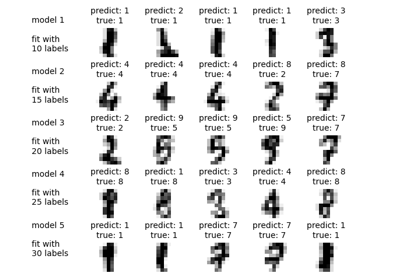

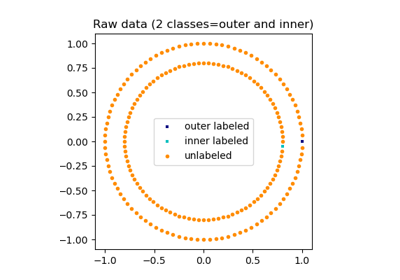

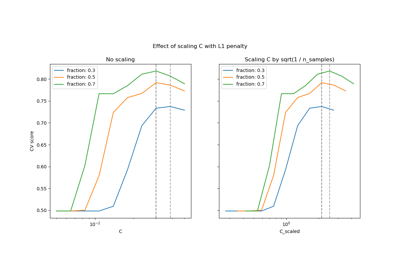

半監督式分類#

關於 sklearn.semi_supervised 模組的範例。

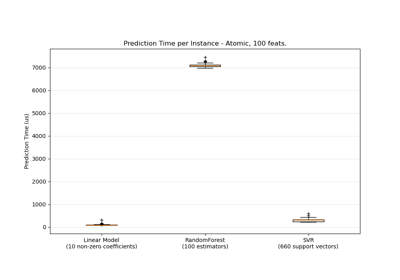

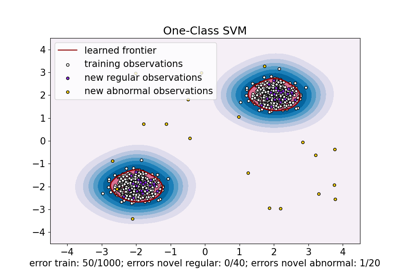

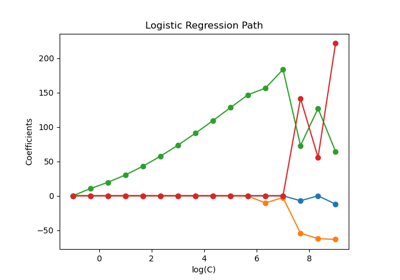

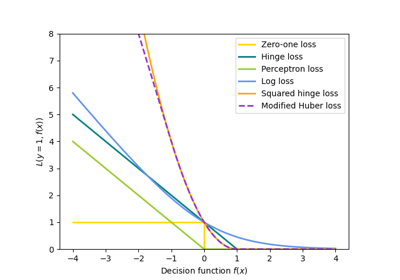

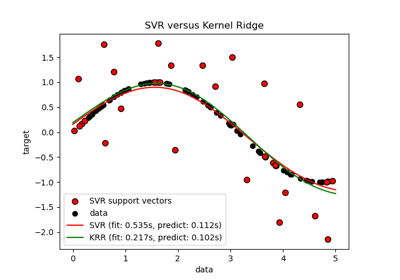

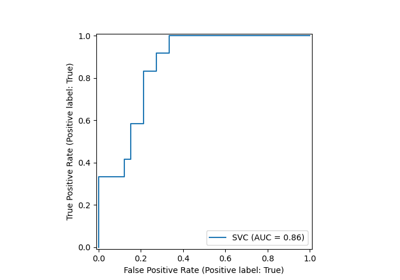

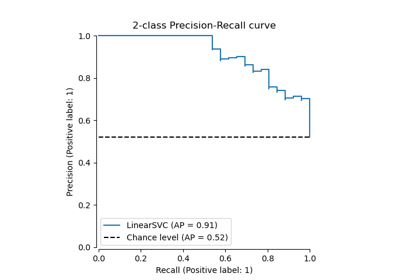

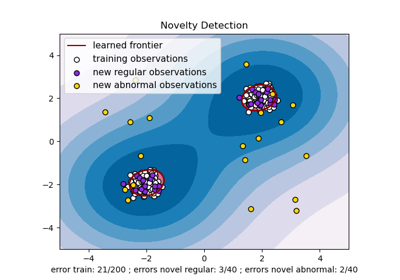

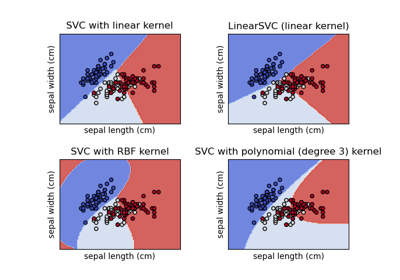

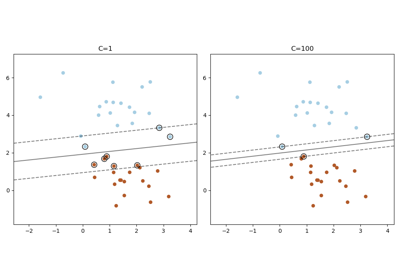

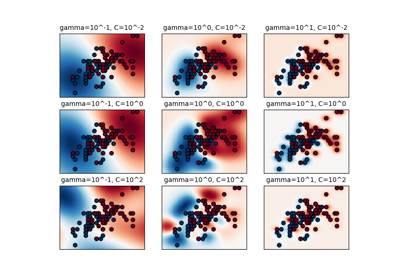

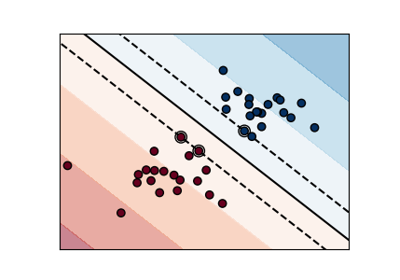

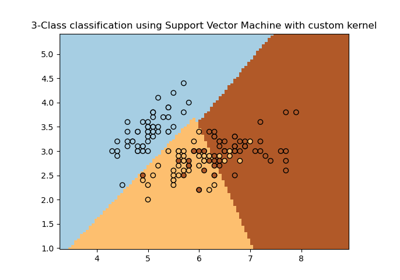

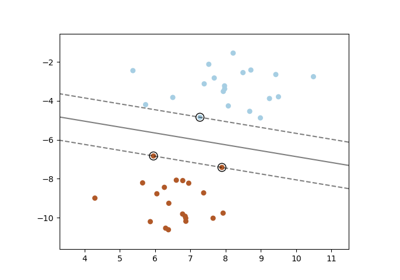

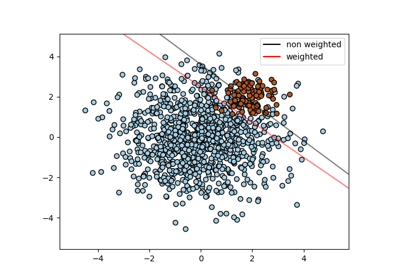

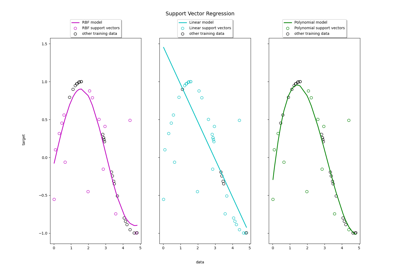

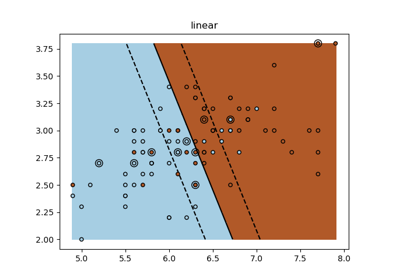

支持向量機#

關於 sklearn.svm 模組的範例。

教學練習#

教學的練習

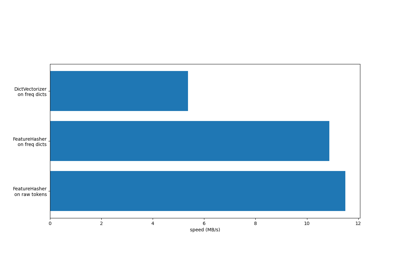

處理文字文件#

關於 sklearn.feature_extraction.text 模組的範例。